Дипфейк (deepfake) — это видеоролики, изображения или аудиозаписи, созданные с помощью искусственного интеллекта (ИИ). Термин возник от сочетания английских слов deep learning (глубинное обучение) и fake (подделка).

В 2014 году вышла реклама шоколада Dove с ИИ-образом молодой Одри Хепбёрн

Как появились дипфейки

Ученые разрабатывают технологии ИИ-контента с конца 1990-х годов. В 1997-м компания Video Rewrite представила программу для создания видео, которая синхронизировала артикуляцию человека со сгенерированной аудиодорожкой. То есть движения лица полностью совпадали со звуком, созданным компьютером. В итоге получалась правдоподобная разговорная мимика.

Термин «дипфейк» появился в 2017 году, когда анонимный пользователь с ником «deepfakes» опубликовал на форуме Reddit ИИ-видео порнографического содержания: он «приклеил» лица знаменитостей к телам актеров. Аноним сделал это с помощью технологии Face Swap (перенос лиц). В то же время в интернете появились дипфейки с Николасом Кейджем — лицо актера добавляли в фильмы, где он не снимался.

Фейковый Николас Кейдж появился в фильме «Человек из стали» — его лицо «прикрепили» к телу актрисы Эми Адамс

С тех пор дипфейки начали набирать популярность и проникать в повседневную жизнь. Сейчас ИИ-технологии активно развиваются: появляются новые возможности по генерации изображений, обработке голоса, объединению компьютерной графики с настоящими видео. Компании-разработчики предлагают профессиональное ПО и любительские приложения. ИИ становится доступен не только узкому кругу лиц, но и обычным пользователям.

Также растет сфера применения ИИ-контента. Его используют в:

- рекламе, маркетинге;

- развлекательных роликах;

- компьютерных играх;

- науке, образовании;

- журналистике;

- живописи, кино;

- индустрии моды;

- дизайне;

- архитектуре.

По данным исследовательской компании Gartner, к 2025 году 10% всего цифрового контента будут создавать с помощью искусственного интеллекта.

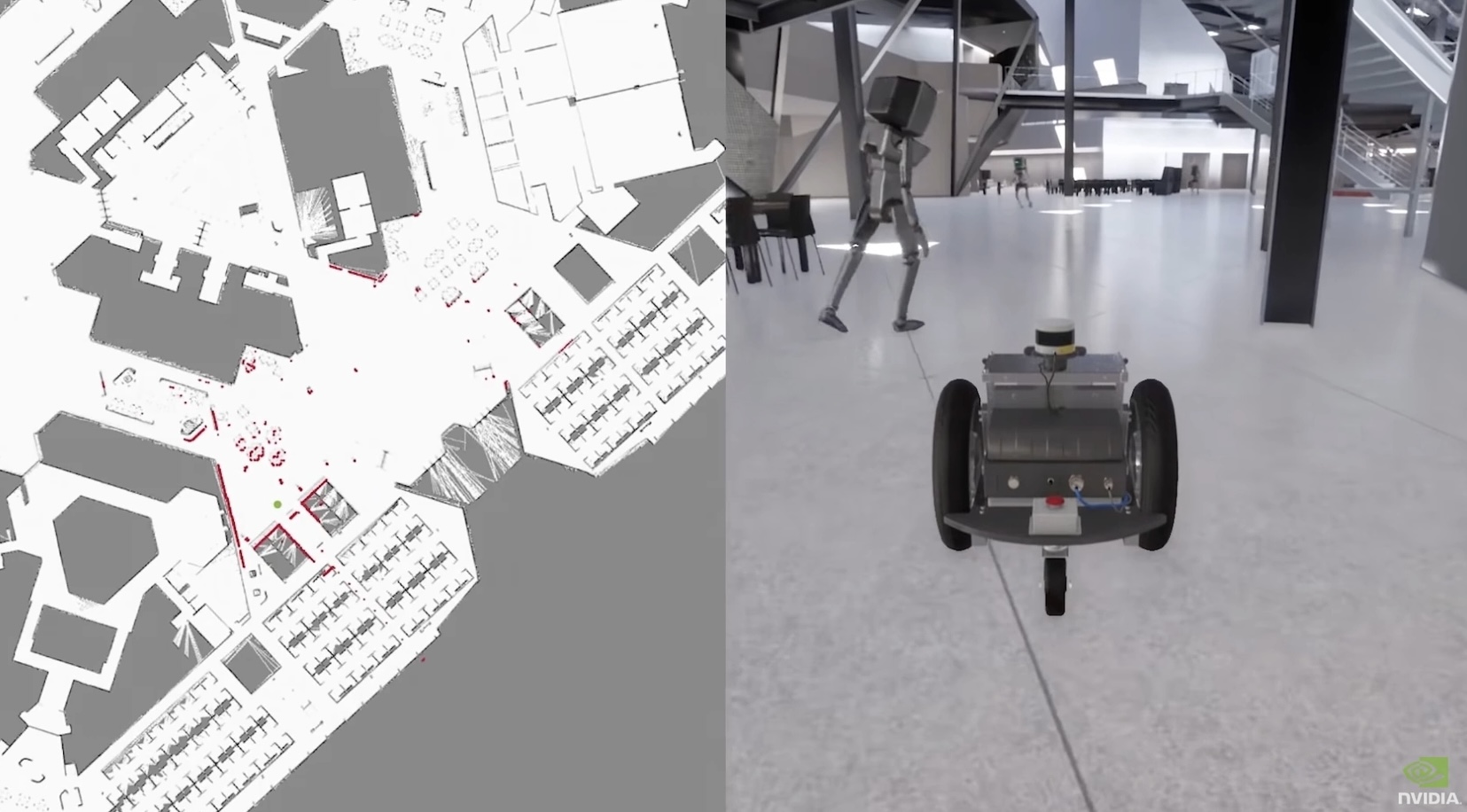

Компания NVIDIA разработала нейросеть GauGAN, которая создает реалистичные иллюстрации из набросков. Технология пригодится для архитектурного проектирования и дизайна видеоигр

Как дипфейки используют в маркетинге

ИИ-контент помогает решать те же задачи бизнеса, что и классические способы продвижения: презентует товары и услуги, привлекает клиентов, улучшает узнаваемость, повышает продажи и прибыль.

Кроме того инструмент позволяет:

Снизить затраты на рекламу. Для создания ИИ-видео и фотографий не нужно привлекать людей для съемок и платить им гонорар. За счет дипфейков компания экономит рекламный бюджет и получает возможность воссоздать образ любого человека, в том числе знаменитости.

Если бренд планирует использовать в рекламе образ реального человека, нужно получить его согласие или разрешение наследников (в силу ст. 152.1 ГК РФ и ст. 11 Федерального закона «О персональных данных»). Если же речь идет об авторских правах (например, когда надо вставить кадр из фильма) — необходимо согласие правообладателей (по ст.1229 ГК РФ).

Нарушение этих норм грозит штрафами (ст 13.11 КоАП РФ), возмещением убытков и запретом на использование контента (ст. 1252 ГК РФ).

Сами дипфейки также признали объектом авторского права в РФ. В 2023 году суд взыскал с компании Roistat 500 тысяч рублей за незаконное использование видеоролика, созданного рекламным агентством Agenda Media Group (AMG).

Предметом разбирательства стало видео с лицом голливудского актера Киану Ривза: на видео герой несколько раз возвращается домой, чтобы посмотреть, выключен ли утюг. В конце концов он забирает прибор с собой

Быстрее адаптировать рекламу. ИИ облегчает и ускоряет создание контента для разных площадок: технологии помогают оперативно сделать ролики для соцсетей, диалоги для радиорекламы, изображения для уличных щитов.

Благодаря дипфейкам бренды быстро адаптируют рекламу под разные условия: например, создают ролик сразу на нескольких языках мира или меняют место действия («рисуют» другой город или страну на фоне). Это экономит время и силы.

В социальном ролике против малярии Дэвид Бэкхем говорит на 9 языках: носители произносят текст (звучит их голос), а ИИ синхронизирует артикуляцию Бэкхема

Экспериментировать. За счет ИИ бренды создают креативную рекламу, выгодно отличаются от конкурентов и удивляют аудиторию. Например, предлагают клиентам одеться в онлайн-примерочной или переносят вымышленных персонажей в реальный мир.

«Сбербанк» воссоздал образ Жоржа Милославского — персонажа фильма «Иван Васильевич меняет профессию». ИИ сгенерировал его голос, внешность и перенес героя в наши дни

Как создают дипфейки

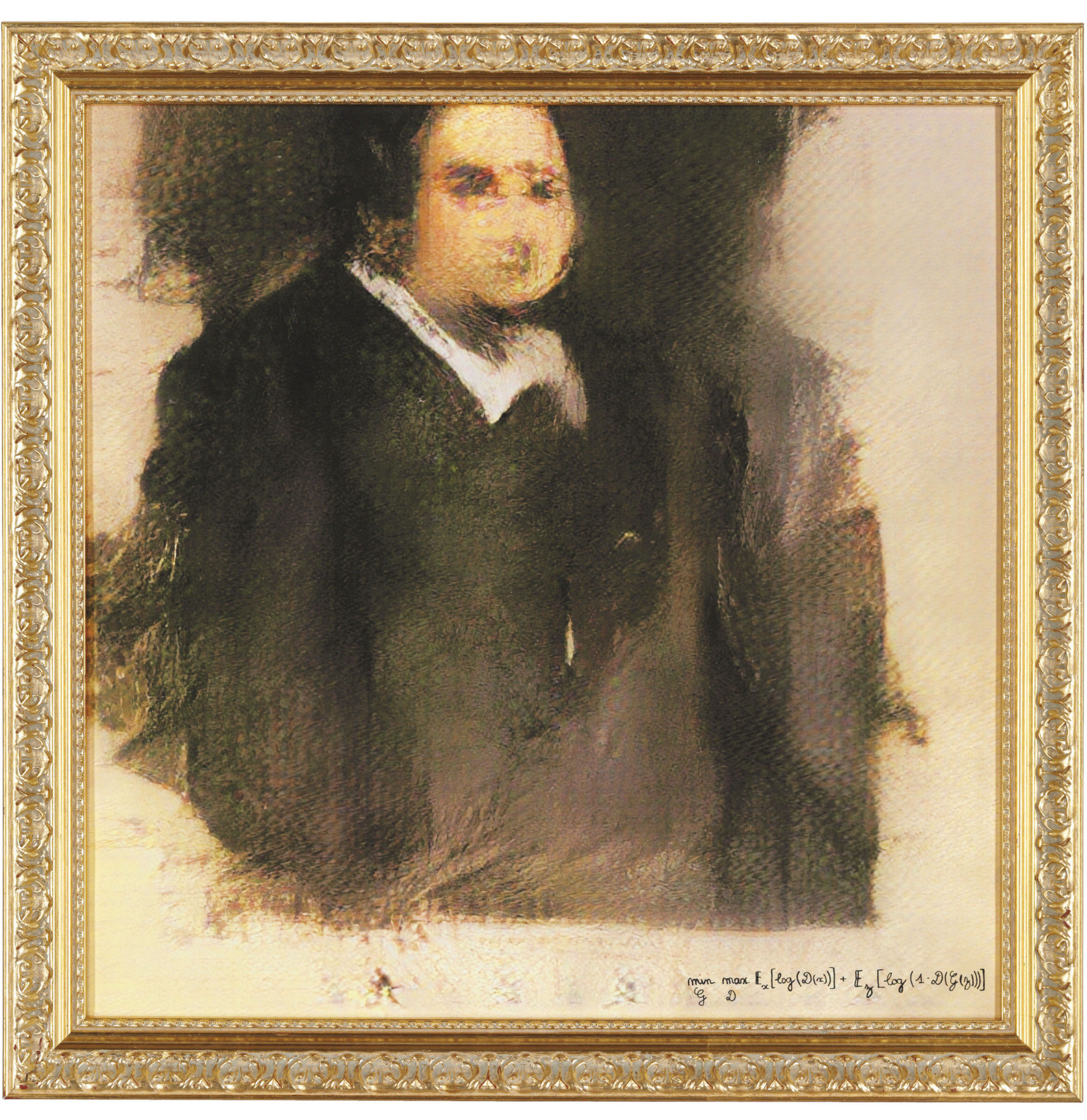

В 2014-м американский исследователь Ян Гудфеллоу разработал генеративно-состязательные сети (GAN) — два машинных алгоритма, которые совместно генерируют ИИ-контент. Именно эту технологию чаще всего применяют при создании дипфейков.

Одна нейросеть (генератор) детально изучает реальные объекты и создает новое изображение, а другая (дискриминатор) — оценивает его реалистичность.

Например, первый алгоритм обрабатывает сотни тысяч снимков человека с разных ракурсов (мимику, выражения лица, характерные черты) и генерирует фейковое фото, а другая сеть проверяет, насколько эта картинка подходит под задачу и является ли уникальной. Таким же образом создают аудио и видео.

Эти две нейросети как бы соревнуются друг с другом: генератор старается обмануть дискриминатор, а последний пытается обнаружить подделку. Так алгоритмы обучают друг друга и совершенствуются, и в результате получается максимально естественный контент.

Картина «Портрет Эдмона Белами» сделана по GAN-технологии. Ее продали на аукционе за 432,5 тысячи долларов

Как сделать дипфейк самостоятельно

Для обычных пользователей есть простые программы, приложения и сервисы, которые позволяют делать дипфейки. Практически весь софт платный, есть пробные периоды.

| FaceSwap (Windows, MacOS, Linux) | Меняет лица на видео. |

| Deepfakes Web (онлайн-сервис) | Создает дипфейк-ролики с заменой лиц. |

| Face Swap Live Lite (iOS, Android) | Позволяет меняться лицами с друзьями в режиме реального времени, а также примерять маски и накладывать на себя лица с других фотографий (например, знаменитостей). |

| Avatarify (iOS, Android) | Оживляет фотографии, добавляет мимику и артикуляцию, накладывает звуковые записи и песни. |

| FacePlay (iOS, Android) | Меняет лицо в стиле комиксов и фильмов, преобразует расу, делает фото, как на документах — всего более 3 тысяч шаблонов и образов |

| ToonMe (iOS, Android) | Делает лицо мультяшным. |

| BabyGenerator (iOS, Android) | Создает фото будущего ребенка на основе снимков родителей. |

| Wombo Dream (iOS, Android) | Генерирует изображения на основе текстового запроса. |

| Synthesia (нейросеть) | Делает видео-дипфейки, превращает текст в речь. |

| Parodist (iOS, Android) | Делает шуточные аудио с голосами знаменитостей. |

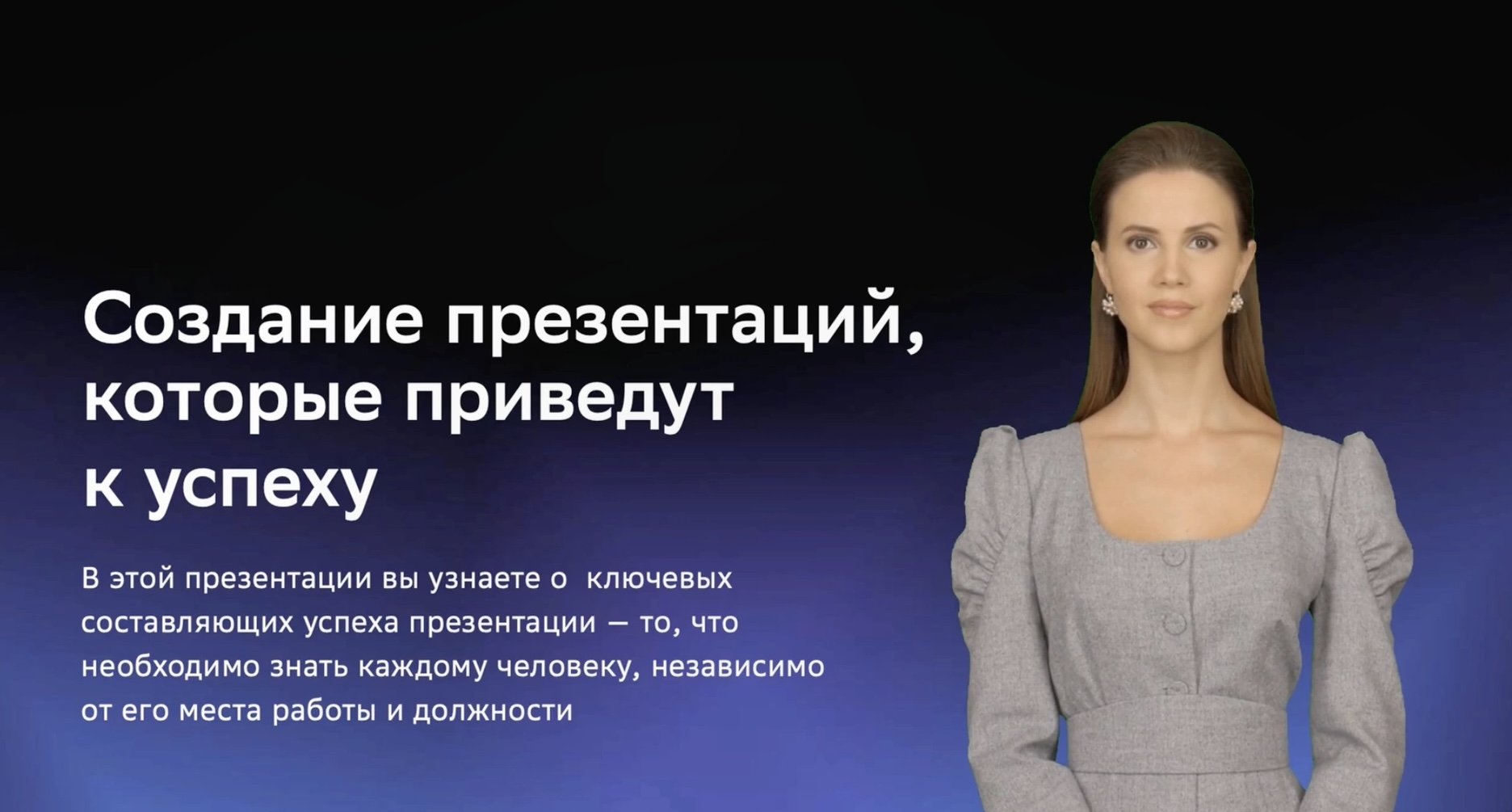

| Visper (онлайн-сервис от «Сбербанка») | Создает видео с ведущими на основе заданного текста. Есть возможность выбрать внешность, голос и стиль речи диктора, добавить жестикуляцию. |

Сервис Visper позволяет делать ИИ-презентации, обучающие видео и новостные ролики с помощью виртуальных ведущих и дикторов

Чем опасны дипфейки и как их распознать

Дипфейки могут порочить честь и достоинство человека (например, при публикации поддельного порнографического контента), а также влиять на политику страны.

В 2018 году в интернете появилось сфальсифицированное видео, где Барак Обама критикует Дональда Трампа. Оно было максимально реалистичным и быстро стало вирусным. Таким способом авторы контента хотели продемонстрировать опасность дипфейков, привлечь внимание к проблеме.

На монтаж видео ушло 56 часов, а работа требовала специальных человеческих навыков

В США дипфейки считаются угрозой нацбезопасности. В Калифорнии законодательно запрещено публиковать ИИ-контент с участием политиков и размещать фейковую порнографию без согласия человека, чей образ взят за основу.

Для обычных людей дипфейки связаны с угрозой мошенничества: злоумышленники подделывают голос близкого человека и крадут у жертвы деньги, используют компрометирующий контент для шантажа, обманывают пользователей с помощью образов известных личностей.

В 2021 году анонимы сделали дипфейк с предпринимателем Дмитрием Мацкевичем и прорекламировали мастер-класс по высоким заработкам. Ссылка на мероприятие вела на мошеннический сайт.

Поскольку дипфейки могут быть опасны для людей, во всем мире разрабатывают алгоритмы для выявления подделок. В 2022 году крупные технологические компании (Adobe, Microsoft, Intel, Sony и другие) создали альянс для борьбы с дипфейками. В 2021 году МВД России заказало исследование по обнаружению сфабрикованного контента.

Самостоятельно распознать дипфейк сложно, но иногда подделку выдают:

- неморгающие глаза на видео;

- рассинхрон в звуке и движении губ;

- слишком гладкая кожа или ее пятнистые оттенки;

- неестественные движения, тени и блики;

- ярко выраженные пиксели.

Многие пользователи приняли за оригинал дипфейк с Папой Римским Франциском в модном пуховике. Но на изображении заметно, что пальцы правой руки выглядят неестественно и как будто «врастают» в стаканчик. Это фото сделала нейросеть Midjourney v5

Чтобы защититься от мошенников, нужно соблюдать правила безопасности:

- доверять только официальным источникам информации;

- настороженно относиться к подозрительным звонкам с просьбой перевести деньги (в идеале — перезвонить человеку, от лица которого был звонок)

- проинформировать близких о разных способах мошенничества;

- регулярно создавать резервные копии на устройствах, установить качественный антивирус, настроить двухфакторную аутентификацию в соцсетях и государственных сервисах (для борьбы со взломщиками, защиты личного контента и персональных данных).

Как и любую технологию создание дипфейков можно использовать как во зло, так и во благо. Благо в нашем случае — это возможность генерировать качественные обучающие или рекламные ролики с минимальными затратами. Для такого контента не играет особенной роли, кто озвучивает текст — реальный человек или аватар. Также можно легко масштабировать такие видео на многоязычную аудиторию и на пользователей разных площадок.

Современные алгоритмы позволяют создавать дипфейки, которые уже практически неотличимы от настоящих видео, поэтому можно не переживать, что пользователей оттолкнет искусственность. Скорее даже легкие искажения в искусственных видео пока только подогревают интерес.

Что касается спорных с моральной и юридической точек зрения способов использования таких технологий, нам уже сейчас определенно нужен какой-то ограничительный механизм, который не позволит эксплуатировать лица реальных людей без их ведома и согласия. На всякий случай стоит договориться с близкими о кодовых словах.

Главные мысли