Модерация — это проверка контента и действий пользователей на соответствие требованиям закона и политике социальной сети.

Модерация помогает вовремя удалить оскорбительные, непристойные или вводящие в заблуждение публикации. А также борется со спамом, троллингом, распространением фишинговых ссылок и другими формами запрещенного поведения.

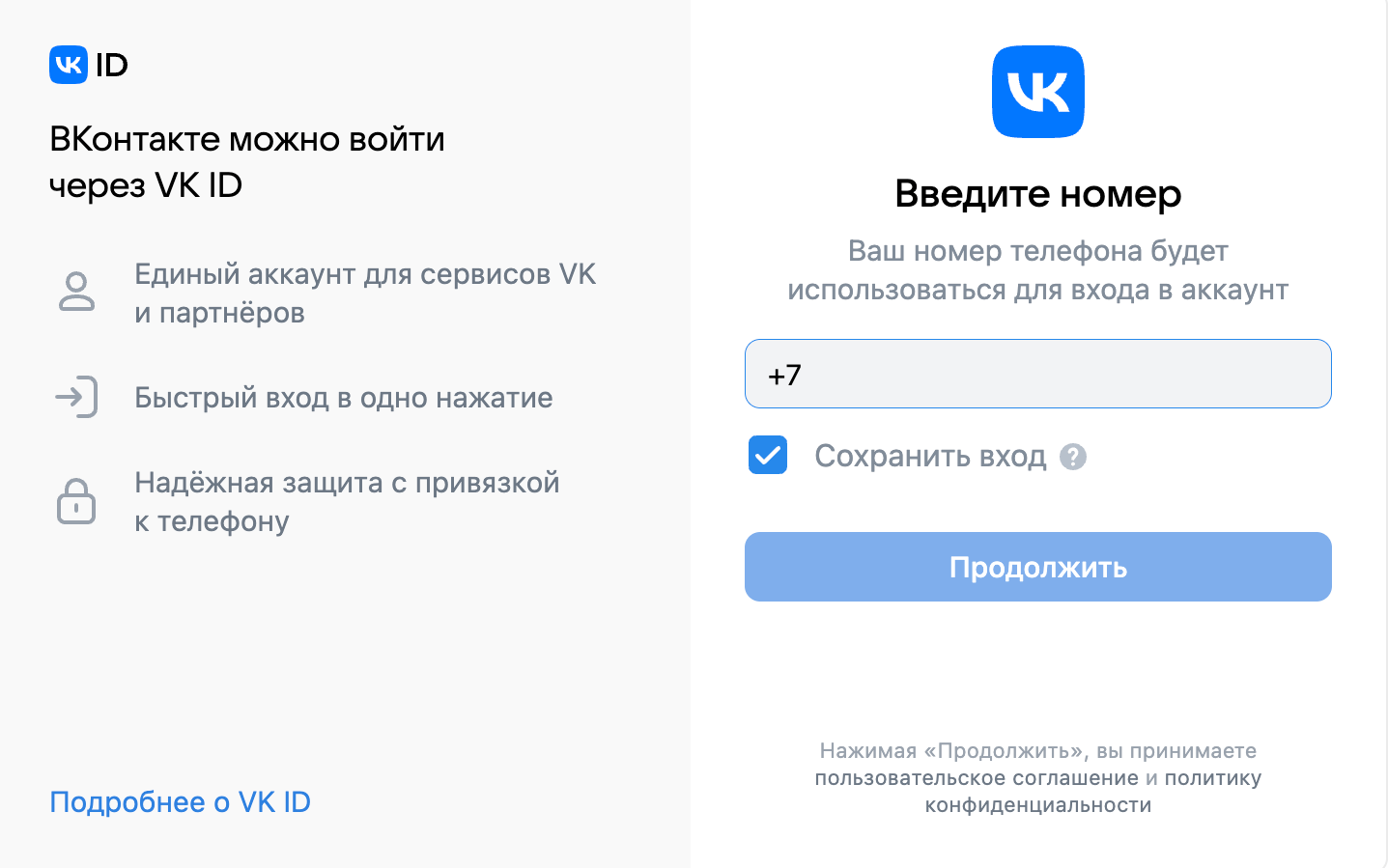

Каждая соцсеть устанавливает свои правила поведения. Когда пользователь присоединяется к платформе, он даёт согласие не только на регистрацию, но и на соблюдение условий площадки. Они определяют, какой контент нельзя публиковать и какие действия нельзя совершать.

При регистрации в VK пользователь автоматически принимает пользовательское соглашение

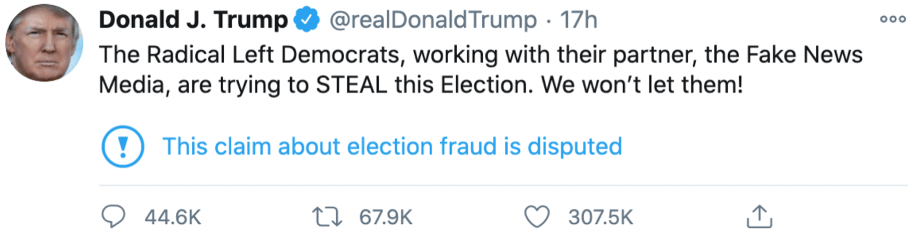

Правила модерации могут меняться по мере возникновения новых проблем. Когда используемых методов защиты становится недостаточно, внедряют новые. Например, в 2020 году, во время президентских выборов США, в «Твиттере» появилось большое количество дезинформации и фэйковых новостей. Чтобы обезопасить аудиторию, платформа стала дополнять посты на политические темы предупреждающими надписями.

Пометка «This claim about election fraud is disputed» («Это утверждение о мошенничестве на выборах оспаривается») позволила снизить градус доверия пользователей к публикациям, содержащим неподтвержденные факты. Источник

Зачем нужна модерация

Ежедневно объём контента, публикуемого в соцсетях, увеличивается. Модерация позволяет обрабатывать множество данных в режиме реального времени и быстро реагировать на появляющиеся проблемы.

Модерация решает несколько основных задач:

- Защищает от нежелательного контента. Помогает предотвратить или быстро заметить неприемлемый контент.

- Обеспечивает безопасность. Останавливает мошенничество, кибербуллинг, харассмент и другие вредоносные действия. Помогает защитить персональные данные пользователей.

- Поддерживает репутацию. Обеспечивает качественный контент. Это позволяет получить доверие пользователей и создать репутацию надеждой соцсети.

- Помогает соблюдать законодательство. Соцсети должны соблюдать местные и международные законы: об авторском праве, защите персональных данных, правах человека и другие. Модерация помогает отслеживать нарушения.

В мае в сети появилась новость о том, что Twitter могут запретить на территории ЕС, если соцсеть не будет соответствовать вступающему в силу закону о борьбе с дезинформацией

Как работает модерация

Для выявления нарушений и оскорбительного контента соцсети используют автоматическую и ручную модерацию.

Автоматическая модерация. Специальные алгоритмы определяют тематику контента и проверяют, соблюдены ли правила площадки. Затем на основании этих данных публикациям и комментариям пользователей выносят вердикт — либо допускают к публикации, либо блокируют. У каждой платформы свои алгоритмы. Например, YouTube активнее всего использует автоматизированные системы для удаления оскорбительных комментариев.

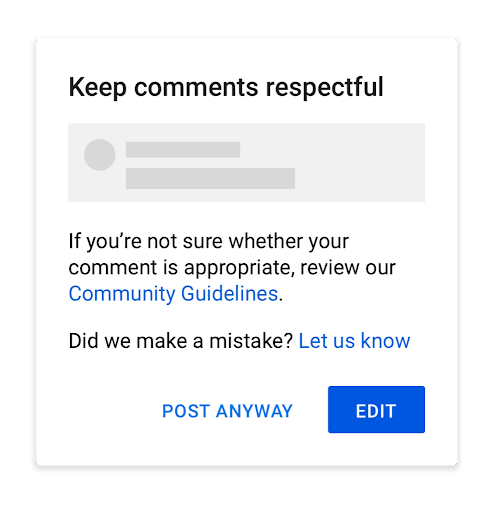

Иногда YouTube не удаляет комментарии, а предлагает пользователю перед отправкой проверить, точно ли он соблюдает правила платформы. Источник

Также для борьбы с токсичностью соцсети прибегают к помощи искусственного интеллекта. Например, внедряют API Google — он использует методы машинного обучения и умеет определять оскорбления, нецензурную лексику и другие нарушения.

Ручная модерация. «Машины» не могут обнаружить всё. Например, какое сообщение действительно разжигает ненависть, а какое — граничит с оскорблением, но приемлемо. Поэтому некоторые публикации отправляются на ручную проверку. Их проверяют живые люди. Это могут быть наёмные работники или добровольцы. Например, Twitter и Facebook* нанимают фрилансеров, которые модерируют контент за деньги. В то же время Reddit полагается на модераторов-добровольцев, которых выбирают из наиболее активных членов сообщества.

Ручная модерация может быть очень полезной при сборе обратной связи. Классическая ситуация: к вам в комменты приходит очень злой человек, говорит, что вы плохо работаете. При грамотном подходе и правильных вопросах вы, как минимум, узнаете, что такое «плохо работаете». В самом лучшем случае получите крупицы адекватной критики, которая важна для компании, а заодно успокоите человека, и он перестанет громко возмущаться. Все в плюсе.

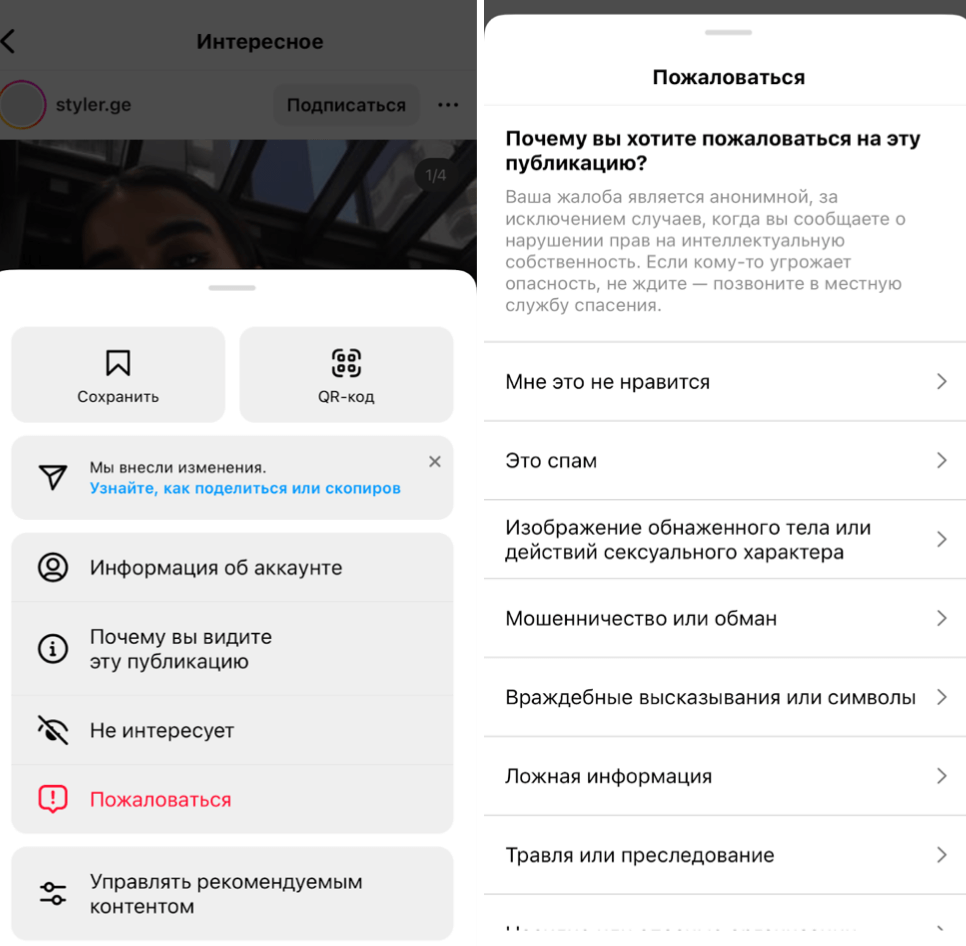

Обычные пользователи тоже могут выполнять роль модераторов. Если, по мнению человека, какой-то контент нарушает правила площадки, он может отправить жалобу.

Обычно у соцсетей есть внутренние правила, согласно которым публикацию удаляют, если какое-то количество пользователей пожаловалось на неё.

В Instagram* пользователь может пожаловаться на контент, который, по его мнению, нарушает правила площадки. Если таких жалоб окажется много, соцсеть удалит публикацию и пришлет её автору предупреждение о блокировке аккаунта в случае дальнейшего несоблюдения правил

Какой бывает модерация

В зависимости от санкций, которые применяют соцсети в случае нарушения правил, выделяют два вида модерации: мягкую и жесткую.

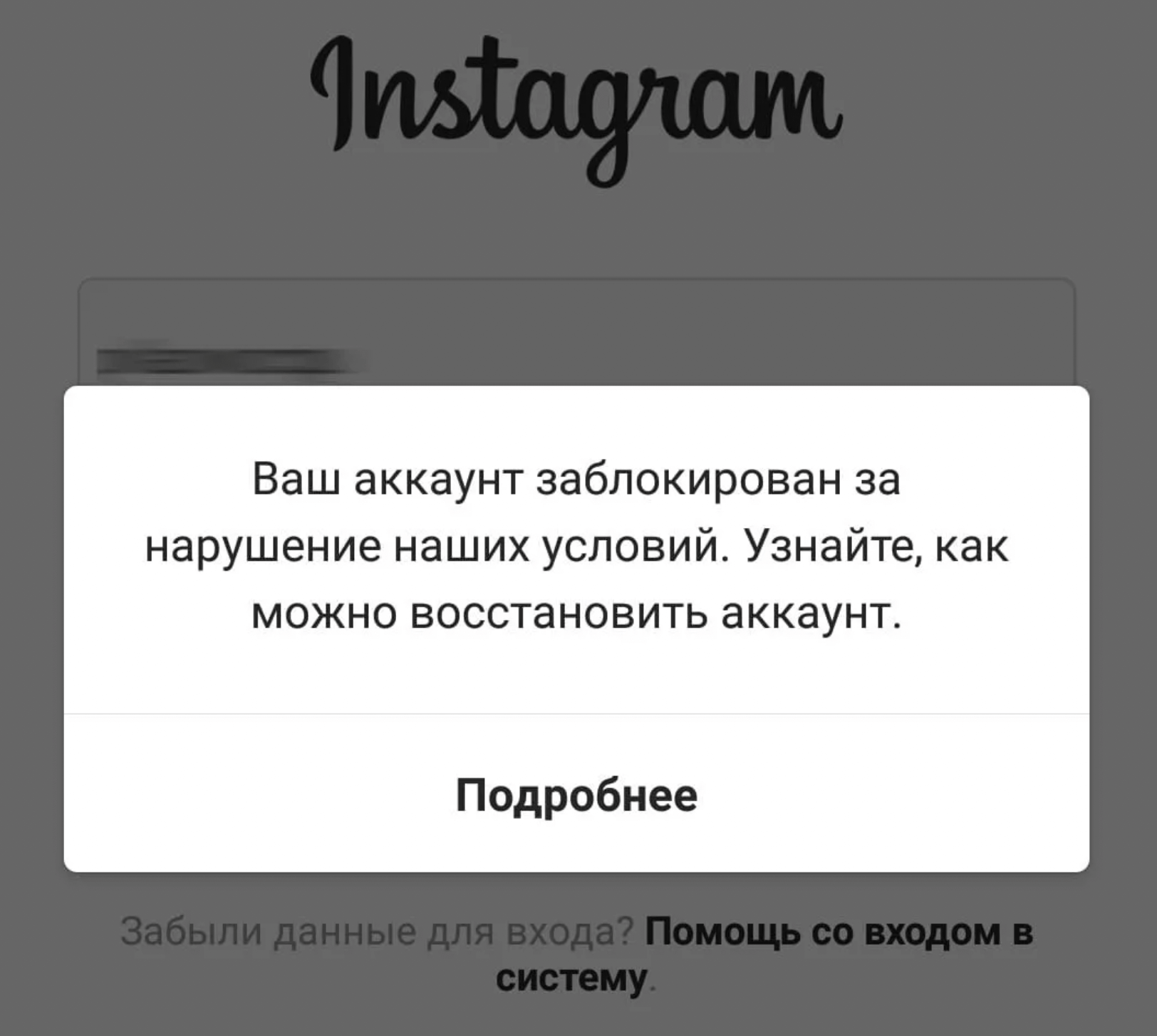

Жесткая модерация. Запрещенный контент незамедлительно удаляют, и другие пользователи не могут получить к нему доступ. Если владелец аккаунта продолжает нарушать правила соцсети, его учетную запись блокируют.

Если пользователь не совершал запрещенных действий, но его аккаунт забанили, он может подать жалобу.

В Instagram* пользователю сразу предлагают перейти по ссылке, которая помогает обжаловать блокировку

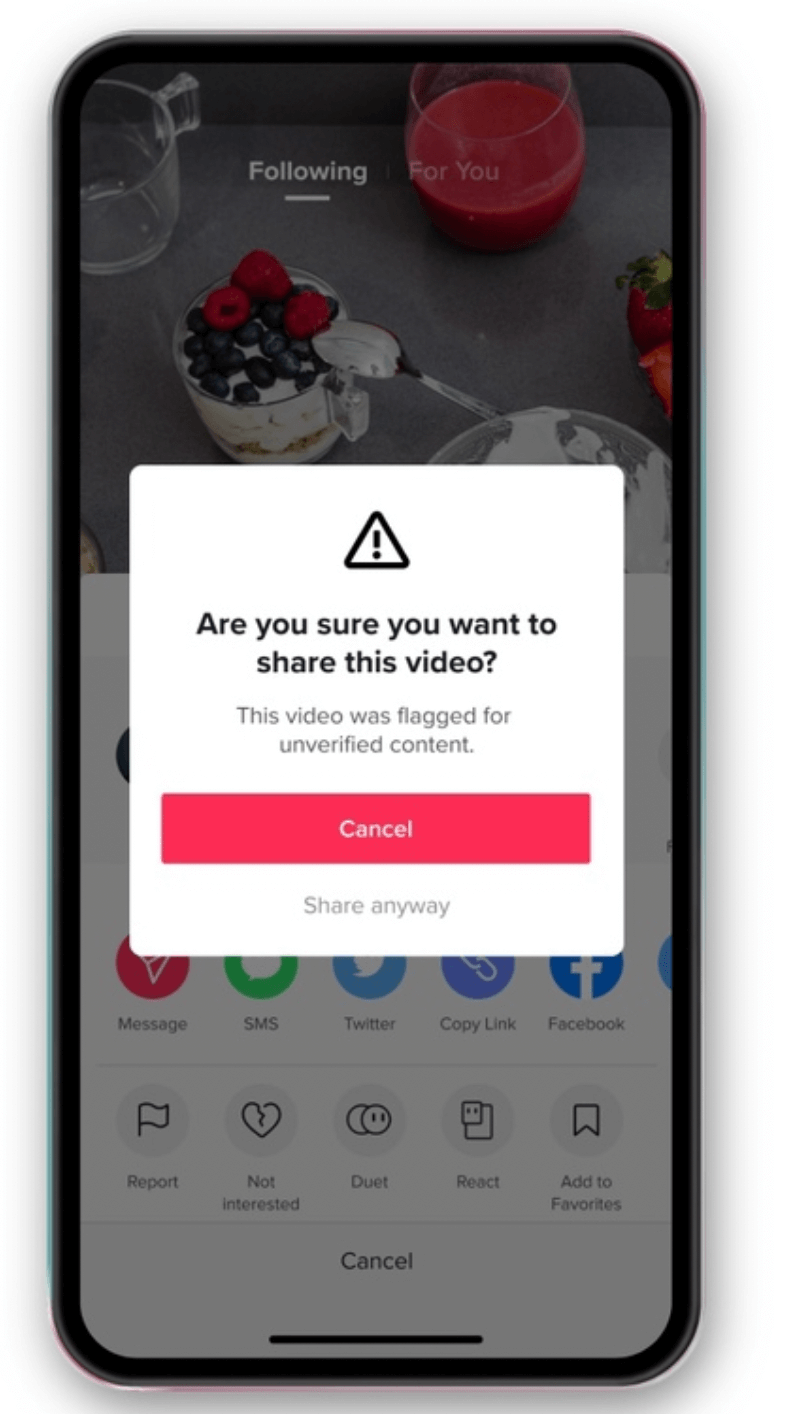

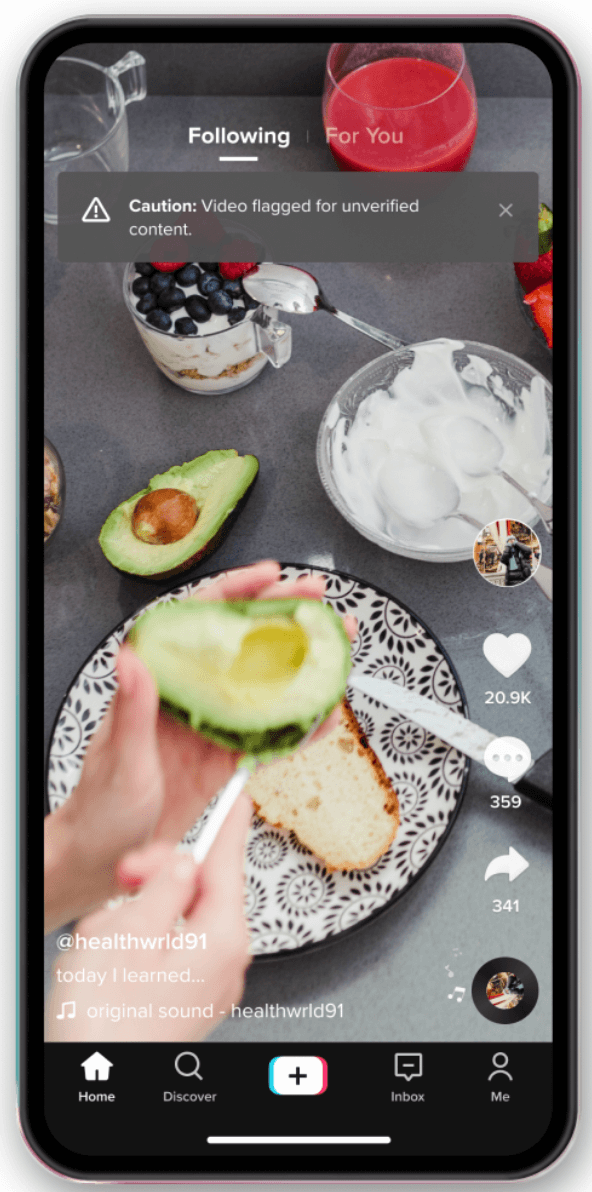

Мягкая модерация. При мягкой модерации платформы не удаляют контент, но информируют пользователей о потенциальных проблемах. Для этого юзеру показывают предупреждающую надпись.

Если TikTok подозревает, что контент пользователя вводит в заблуждение, ему показывают предупреждающую надпись, которая призывает убедиться в достоверности информации

Иногда после того, как пользователь получает предупреждение, его публикации сопровождаются специальными маркировками.

TikTok маркирует ролики баннером со словами «Предупреждение: видео может содержать непроверенную информацию». Источник

Главные мысли