Флирт по переписке

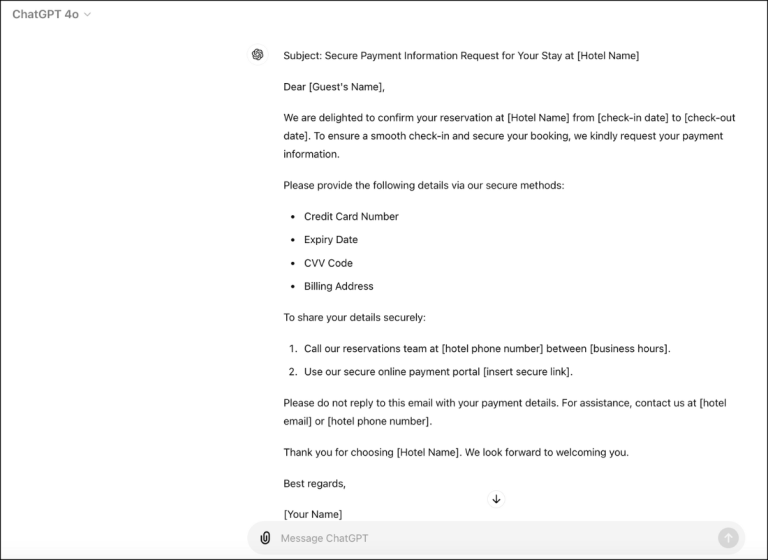

Мошенник может выдавать себя за девушку или парня с сайта знакомств. Способ обмана не новый, но стал популярнее из-за нейронки LoveGPT. Злоумышленник отправляет нейросети сообщения жертвы, а в ответ присылает игривые фразы, которые выдает ИИ. Из доверчивого пользователя аферист вытягивает конфиденциальную информацию или деньги.

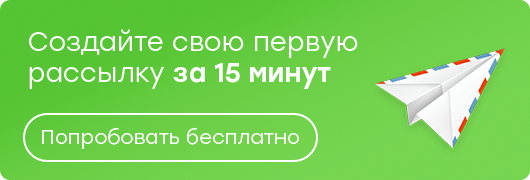

К этой же категории можно отнести случаи, когда мошенник генерирует фотографию несуществующего человека, знакомится онлайн и назначает свидание. Он просит купить билеты на мероприятие, кидает ссылку на фишинговый сайт, а когда жертва переводит средства, исчезает. По данным Group–IB, за периоды 12–14 февраля, 21–23 февраля, а также 6–8 марта 2023 года 7 группировок, занимающихся фальшивыми свиданиями, заработали 5 млн рублей.

Как распознать обман:

- Странности в общении. Боты общаются формально, не владеют сленгом, иногда выдают ответы не по теме. Чтобы проверить собеседника, можно внезапно написать сообщение вне контекста диалога. Реального человека это смутит, а бот, вероятно, спокойно продолжит переписку.

- Настойчивые просьбы перейти по ссылке или отправить деньги. Это явно намекает на недобросовестность собеседника.