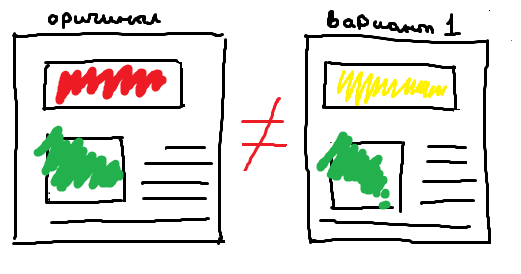

В A/A-тесте победителя быть не должно. Если он есть, значит, что-то пошло не так.

Что такое А/А-тесты и нужно ли их проводить

Зачем нужен A/A-тест

Когда я впервые услышала про А/А-тест, в голове сразу возник вопрос: «А зачем это нужно, если разницы в результатах не будет?» Но, как оказалось, в этом и заключается суть такого эксперимента.

По данным Instapage, около 80% результатов А/Б-тестов не подтверждаются на практике. Это еще хорошо, если после внесения изменений конверсия останется на прежнем уровне. Бывает, что результат ухудшается. И, помимо потерянного времени, компания начинает терять деньги. Чтобы этого избежать и придумали А/А-тесты.

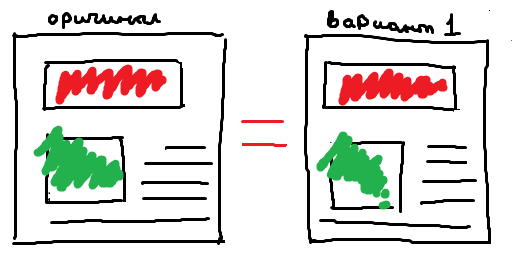

Главная цель А/А-теста — показать, можно ли доверять результатам эксперимента, который будет запущен в тех же условиях, но уже с разными вариантами страницы. Если в ходе А/А-теста победителя выявить не удалось, можно запускать А/Б-тест. В противном случае придется проверить настройки сервиса и однородность выборки. Таким образом, А/А-тест предоставляет контрольные данные для проверки точности А/Б-теста.

Если говорить о конкретных задачах, то А/А-тест чаще всего используют, чтобы:

Проверить, правильно ли работает платформа для тестирования (например, Google Optimize). Если А/А-тест, запущенный в сервисе, покажет победителя, значит, есть проблемы с настройками эксперимента или с самим сервисом. О том, что делать в такой ситуации, поговорим чуть ниже.

Я обычно запускаю A/A-тест, когда клиент хочет получить дополнительные доказательства того, что его платформа для тестирования работает правильно. На самом деле нет лучшего способа сделать это, чем взять точно такую же страницу и протестировать ее против самой себя без каких-либо изменений. По сути, мы обманываем платформу и смотрим, поймает ли она нас!

Определить базовый уровень конверсии. С помощью А/А-теста можно определить доверительный интервал, в рамках которого изменения конверсии могут быть случайными и не зависеть от изменений на странице. Например, в ходе А/А-теста одна и та же страница показала конверсию 2% и 3%. Значит, если при А/Б-тесте конверсия попадет в диапазон от 2% до 3%, вносить изменения на страницу не стоит, так как они не повлияют на результат.

Так, в компании Avast после проведения А/А-теста приняли внутренние рекомендации по тестированию. Эксперимент помог компании определить, что любые изменения конверсии в диапазоне 5% могут быть вызваны случайными факторами и не могут служить сигналом к внедрению изменений.

Оценить минимальный объем выборки и время проведения эксперимента для конкретной страницы. Некоторые программы для тестирования объявляют выигрышную страницу преждевременно. Запустив А/А-тест, вы увидите, сколько участников на самом деле потребуется, чтобы считать один из вариантов при А/Б-тесте выигрышным. Это произойдет, когда результаты А/А-теста начнут выравниваться.

Как провести А/А-тест

Для начала настройте тест в выбранном инструменте, указав в качестве варианта для сравнения ту же самую страницу без изменений. При этом используйте сервис, в котором запускаете или планируете запускать А/Б-тесты.

Если вы еще никогда не проводили А/Б-тесты, проще всего начать с Google Optimize. Этот сервис легко настроить, он бесплатный и легко интегрируется с Google Analytics.

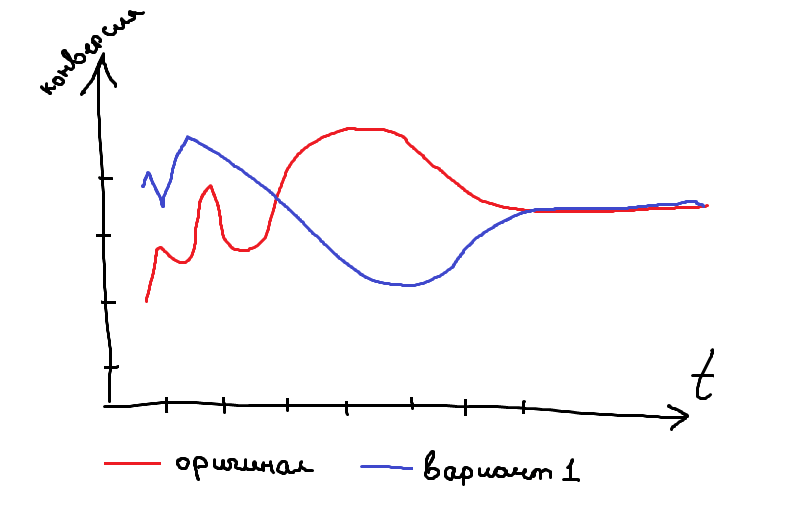

После запуска теста, следите за его результатами. Поначалу данные могут сильно различаться, но с ростом количества участников эксперимента, они начнут выравниваться.

Не торопитесь завершать эксперимент слишком рано. Чем дольше вы его проводите, тем точнее будут результаты. Бывает, что А/А-тест показывает разницу только потому, что ему не хватает нужного количества данных для правильных выводов. Поэтому подождите хотя бы 1 месяц, а потом уже приступайте к анализу результатов.

Можно ориентироваться на размер выборки, который рассчитывается с помощью любого онлайн-калькулятора. Но если нужное количество пользователей вы набрали, а конверсия по двум страницам еще не выровнялась, лучше подождать пару недель, прежде чем приступать к анализу результатов.

Если А/А-тест не показал разницы между вариантами или она оказалась минимальна, поздравляем, вы можете со спокойной совестью запускать А/Б-тест и полагаться на его результаты. При этом важно, чтобы инструмент для тестирования не смог определить победителя. Поэтому обращайте внимание на показатель статистической значимости, он должен оказаться ниже 95%. Это означает, что ни один из вариантов не может быть признан выигрышным.

Если А/А-тест выявил победителя (а это плохо), то причины могут быть такие:

Ошибка теста (элемент случайности). Как у любого эксперимента, у А/А-теста тоже есть определенная степень достоверности. В теории при стандартной значимости в 95% каждый 20 А/А-тест будет показывать ложноположительный или ложноотрицательный результат. На практике, эксперты говорят, что сервисы объявляют победителя в 50-70% A/A-тестов (значимость от 95% до 99%). Такова статистика. Поэтому лучше повторить А/А-тест 2-3 раза, и только если результат повторится, пойти копаться в настройках сервиса и эксперимента.

Технические проблемы. Если несколько А/А-тестов подряд определяют победителя, и им признается основная страница, а не ее дубль, возможно, проблема с настройками эксперимента или в самом сервисе.

Проверьте, чтобы:

- данные в сервисе совпадали с данными веб-аналитики (количество посетителей, конверсия);

- скорость загрузки каждого варианта была примерно одинаковой (бывает смена варианта даже на тот же самый замедляет загрузку сайта, что, естественно, отражается на конверсии);

- обе страницы выглядят одинаково на всех устройствах и во всех браузерах. Разница может появиться, например, из-за «эффекта мерцания», когда пользователь сначала видит один вариант, а потом он меняется на другой пусть и идентичный первому.

Проблемы с инструментом. Если вы провели уже несколько тестов, не обнаружили технических неполадок и ошибок в настройках эксперимента, а А/А-тесты продолжают выявлять победителя, попробуйте использовать другой инструмент для тестирования.

Минусы А/А-теста

У А/А-тестов много противников, которые считают их бесполезной тратой времени. Вот основные аргументы, которые они приводят:

Тест занимает много времени. На проведение А/А-теста требуется заложить около месяца, чтобы добиться нужной точности эксперимента. И это при хорошем трафике.

Если проект только стартует, проводить А/А-тест бессмысленно. Лучше постараться сделать сайт логичнее и понятнее, собрав обратную связь от представителей целевой аудитории.

Результат не гарантирован. Выше я уже описала, какие проблемы могут возникнуть при проведении А/А-теста и почему не всегда стоит доверять полученному результату.

Чтобы избежать перечисленных минусов, можно использовать другие способы, которые помогут проконтролировать качество эксперимента.

Как еще контролировать качество эксперимента

В чистом виде А/А-тест — слишком затратное решение. Поэтому более разумно использовать другие варианты, чтобы подтвердить правдивость результатов А/Б-экспериментов:

Провести А/А/Б — тест. Компромиссный вариант. Можно запустить в ротацию сразу три варианта страницы — оригинал, еще один оригинал и страницу с изменениями. Так вы сэкономите время и убьете сразу двух зайцев. Однако у этого способа тоже есть свои минусы: на такой эксперимент требуется больше времени, чем на классический А/Б-тест, и если будет обнаружена разница между одинаковыми вариантами, то и результатами всего эксперимента нельзя будет пользоваться.

Добавить инструмент аналитики. Это отличный способ проверить инструмент для тестирования. Самое простое — добавить Google Analytics к тому же Google Optimize. И если значительной разницы между данными (количеством посетителей, значением конверсии) не будет, значит, инструмент для тестирования работает корректно. Если увидите разницу в данных, попробуйте запустить А/А-тест и посмотреть на его результаты.

Следить за экспериментом. Одна из главных причин, почему А/А-тест может выявить победителя, — неоднородность выборки. При проведении А/Б-теста стоит следить, чтобы между различными сегментами посетителей не было значительной разницы в разрезе вариантов. Другими словами, чтобы структура аудитории по полу, устройствам, географии была примерно одинакова для каждого варианта. Также варианты сайтов должны отличаться только тем, чем вы запланировали, а для этого важно отслеживать возникновение любых технических проблем и устранять их как можно быстрее.

Если вы все-таки решили проводить А/А-тесты, не стоит делать это перед каждым экспериментом. Полезно запустить такой тест, если вы только начинаете заниматься сплит-тестированием или хотите сменить сервис для А/Б-тестов.

СВЕЖИЕ СТАТЬИ

Не пропускайте новые статьи

Подписывайтесь на соцсети

Делимся новостями и свежими статьями, рассказываем о новинках сервиса

«Честно» — авторская рассылка от редакции Unisender

Искренние письма о работе и жизни. Свежие статьи из блога. Эксклюзивные кейсы и интервью с экспертами диджитала.