YouTube, Instagram*, Facebook*, Tik-Tok…

Соцсети блокируются, а рассылки остаются эффективными. По данным Unisender 2019–2024, блогеры и бизнес стали в 2 раза чаще

отправлять электронные письма.

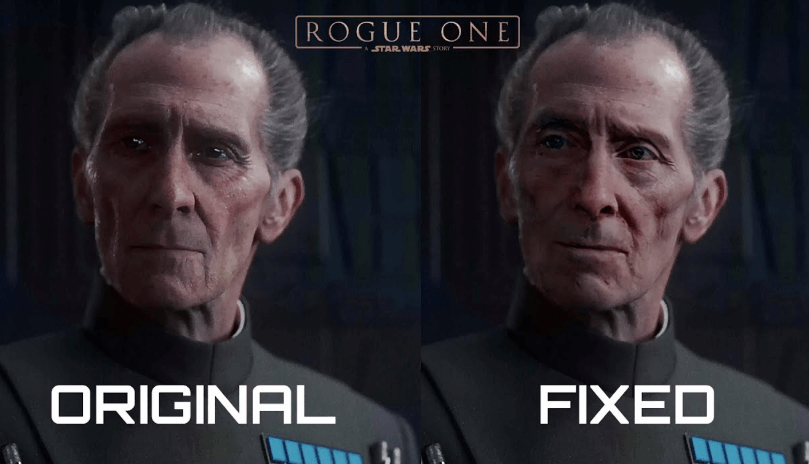

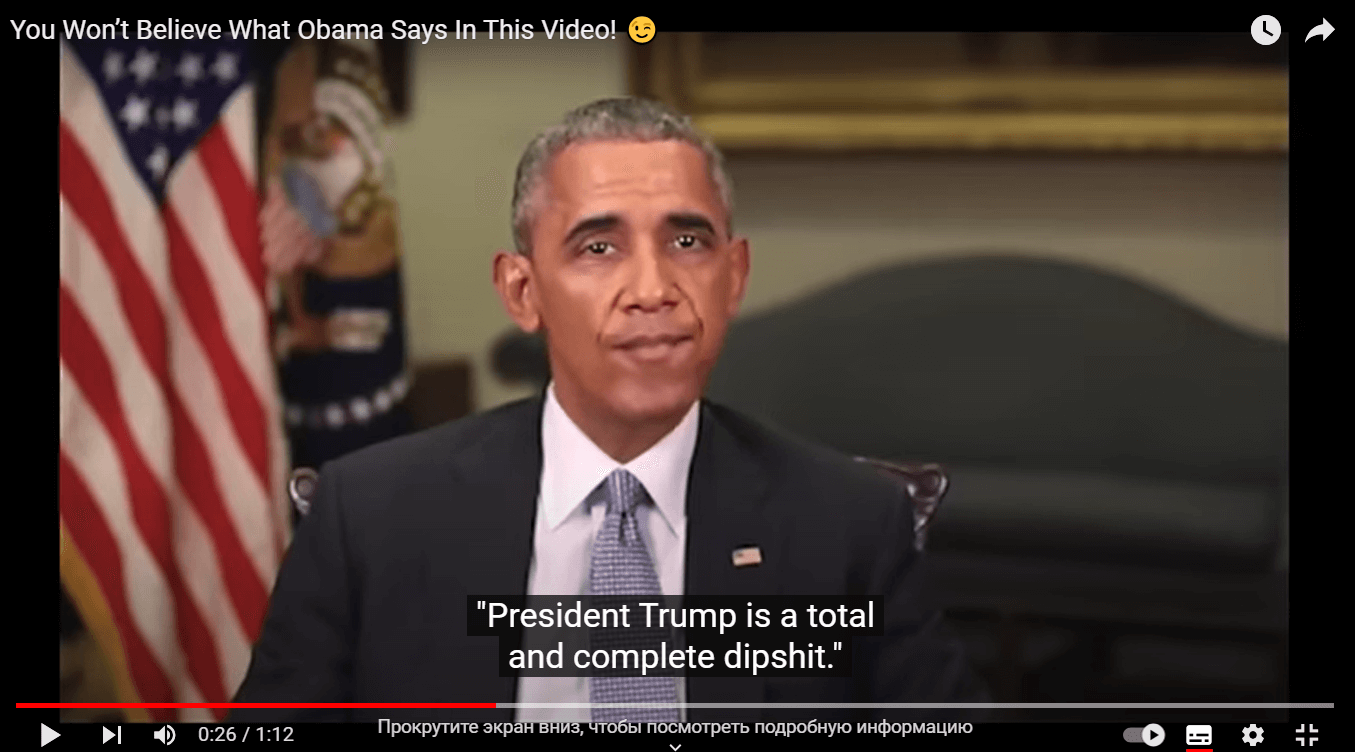

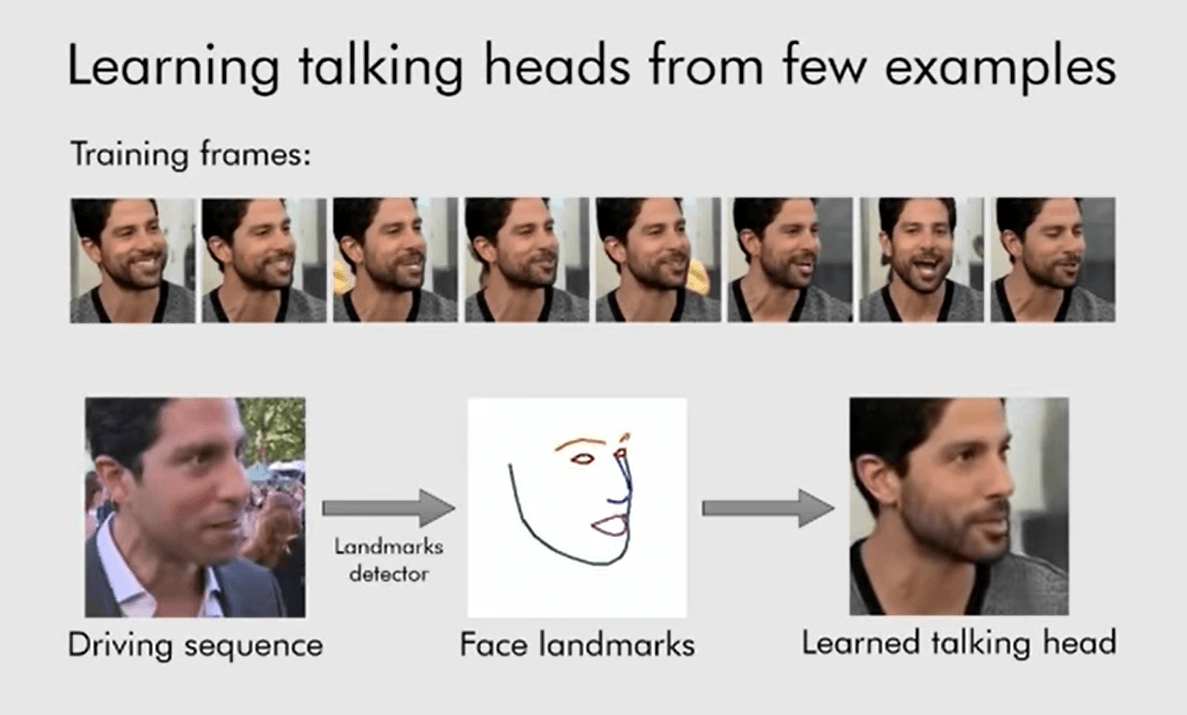

Искусственный интеллект может создавать двойников человека в видео, изображениях и аудиозаписях. Такие двойники называются дипфейками. Иногда дипфейки помогают режиссерам, сценаристам или актерам озвучки. А иногда их используют мошенники, чтобы обмануть людей.

В статье подробно разбираем плюсы и минусы использования дипфейков. А также рассказываем, как отличить подделку от оригинала и как защитить себя от дипфейков.