Внутри конструктора Unisender — ИИ-ассистент. Поможет составить тему, проверить ошибки в тексте, нарисовать картинку. И даст рекомендации как маркетолог или психолог.

Контента в интернете очень много. И сделать что-то уникальное все сложнее и сложнее — практически обо всем кто-то уже писал или рассказывал. А что делать, если вы хотите написать о чем-то, о чем рассказывали уже тысячу раз? Решили разобраться и опросили для этого разных экспертов: главреда, SEO-специалиста, специалистов по рекомендательным системам и внешним площадкам, юристов.

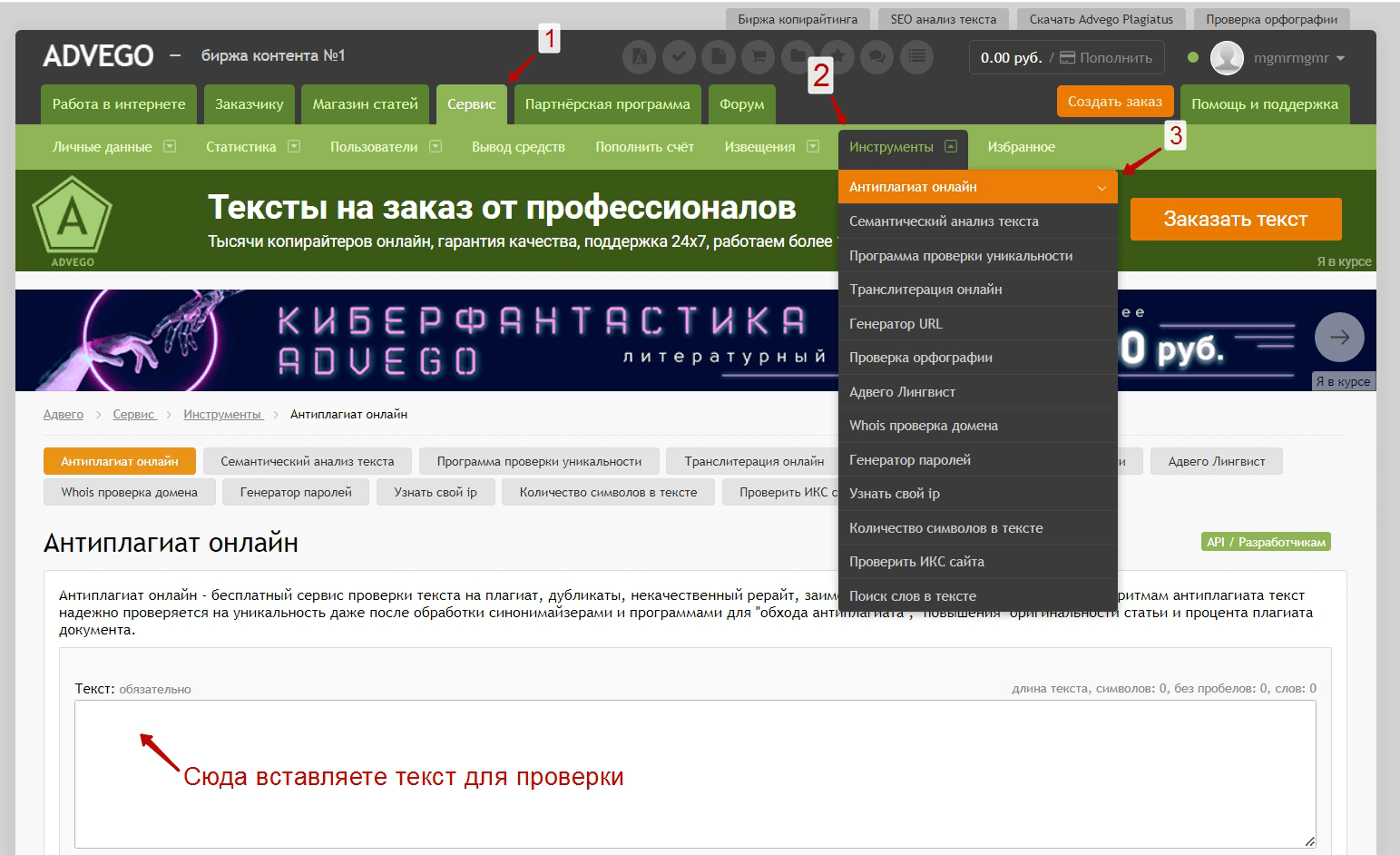

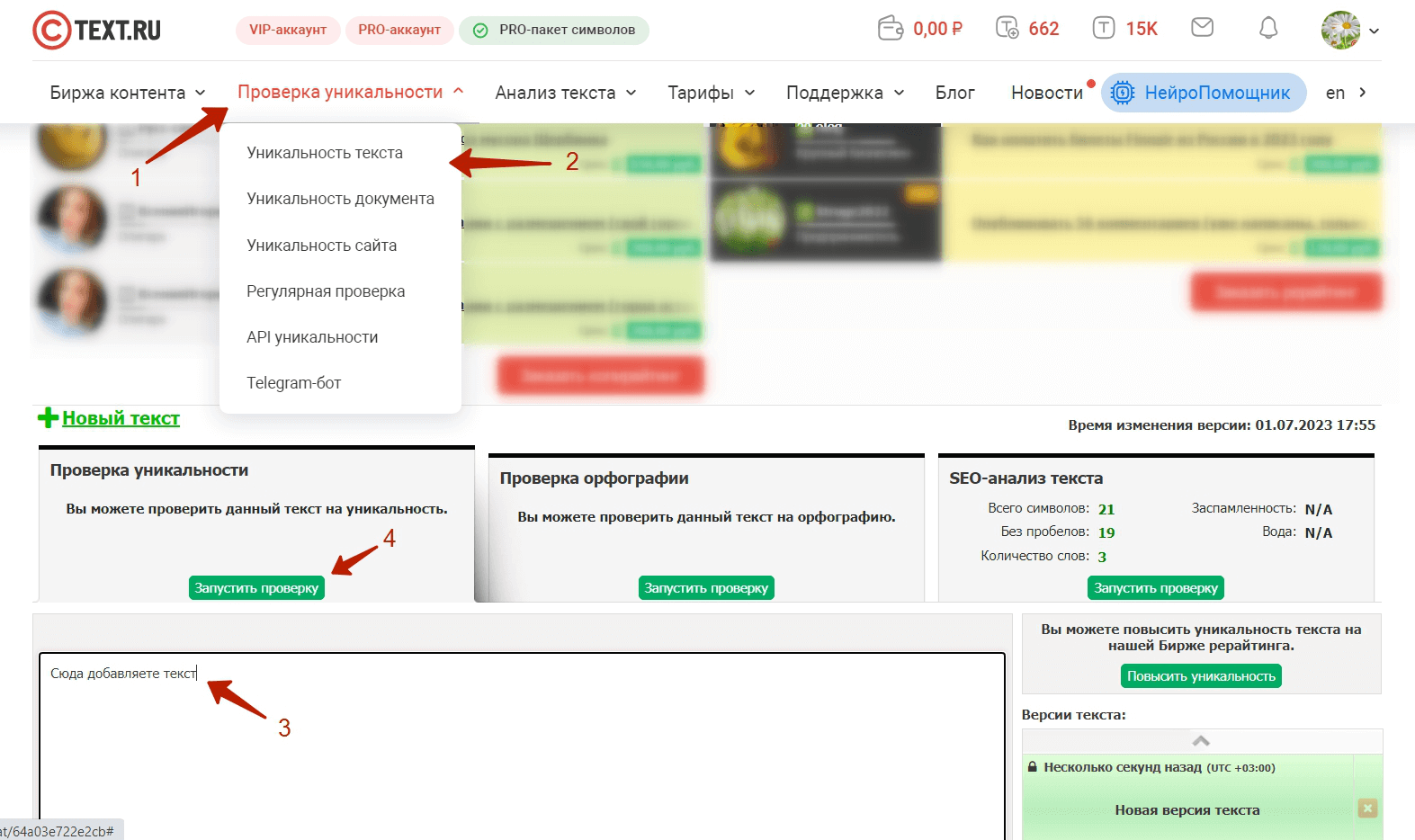

Материала получилось много, поэтому мы разделили его на 3 части. Это первая часть, в ней рассказываем о том, что такое уникальность контента, как она рассчитывается и как влияет на ранжирование сайтов в выдаче.